Chers amis de l’excellence et de la performance, alors que nous naviguons dans les eaux complexes de l’informatique moderne, il est un domaine où la quête de la perfection s’exprime avec une acuité particulière : celui de l’optimisation des compilateurs pour architectures modernes. C’est une discipline qui, à l’image de nos plus grands artisans, exige précision, vision et un sens aigu du détail, car elle est le véritable moteur de la puissance de calcul que nous tenons souvent pour acquise. Pour l’amour de la France et de son esprit d’innovation, plongeons ensemble dans cet univers fascinant.

Aux Sources de la Performance : Pourquoi l’Optimisation est une Noblesse ?

Quand on parle d’optimisation des compilateurs pour architectures modernes, on évoque bien plus qu’une simple amélioration technique ; c’est une philosophie, une quête incessante de l’efficience qui résonne avec notre héritage français de clarté et de logique. Pourquoi, me direz-vous, cette attention particulière ? Simplement parce qu’un programme, aussi élégant soit-il dans sa conception, ne révèle sa pleine splendeur qu’une fois exécuté avec la plus grande vélocité sur les machines les plus avancées. Les architectures modernes, avec leurs cœurs multiples, leurs hiérarchies de mémoire complexes et leurs unités de calcul vectorielles, sont de véritables cathédrales technologiques. Sans une optimisation astucieuse, nos logiciels resteraient des promesses inachevées, des sonates sans leur virtuosité.

Le Dr. Henri Beaumont, chercheur émérite en informatique théorique, aime à dire : « L’optimisation, c’est l’art de libérer le potentiel intrinsèque du code. C’est transformer une belle idée en une réalité fulgurante, sans altérer sa substance. » Il s’agit de faire en sorte que chaque cycle d’horloge de nos processeurs ne soit pas une dépense vaine, mais une contribution significative à l’avancement de nos calculs. C’est l’économie au service de la performance, la frugalité des ressources pour une exécution maximale.

Qu’est-ce que l’optimisation des compilateurs, et pourquoi est-elle cruciale aujourd’hui ?

L’optimisation des compilateurs est le processus par lequel un compilateur transforme un code source en un code machine plus rapide, plus petit ou plus efficace en énergie, sans en changer le comportement sémantique. Elle est cruciale aujourd’hui car les architectures matérielles sont devenues extrêmement complexes, rendant indispensable l’adaptation du code pour exploiter pleinement leurs capacités (parallélisme, gestion de la mémoire cache, vectorisation).

Dans le monde effréné de la technologie, où chaque nanoseconde compte, l’optimisation n’est pas un luxe, mais une nécessité. Des supercalculateurs qui modélisent le climat aux smartphones qui traitent nos requêtes en temps réel, la performance est reine. Un compilateur qui optimise efficacement peut réduire la consommation énergétique, augmenter la vitesse d’exécution de manière spectaculaire, et même permettre à des algorithmes complexes de voir le jour sur des plateformes contraintes. C’est une symphonie de logique et d’ingénierie qui rend le monde numérique plus fluide, plus réactif, plus… français dans sa quête d’excellence.

Les Outils du Maître Compilateur : Ingrédients et Techniques Clés

Tel un chef étoilé préparant un festin, le compilateur s’appuie sur une panoplie d’« ingrédients » et de « techniques » pour transformer un simple code en une œuvre d’art de la performance. Comprendre ces éléments, c’est saisir la complexité et la beauté de l’optimisation des compilateurs pour architectures modernes.

Quels sont les principaux ingrédients et outils nécessaires à l’optimisation des compilateurs ?

Les principaux ingrédients et outils comprennent des analyses de code (flux de données, dépendances), des transformations de code (boucles, registres, mémoire), et des modèles d’architecture spécifiques. Les outils sont les compilateurs eux-mêmes (GCC, Clang, Intel C++ Compiler), leurs bibliothèques d’optimisation (LLVM), et des profileurs de performance qui identifient les goulots d’étranglement.

Au cœur de cette cuisine sophistiquée, nous trouvons d’abord les « analyses ». Avant toute transformation, le compilateur doit « goûter » le code, en comprendre la structure intime, les dépendances, les chemins d’exécution possibles. C’est comme un architecte étudiant les fondations d’un bâtiment avant d’envisager des modifications. On y analyse le flux de données, l’aliasing, les dépendances de boucles, autant de concepts qui révèlent les opportunités d’amélioration.

Viennent ensuite les « transformations », les gestes précis du cuisinier. Celles-ci sont multiples et variées, chacune ayant un rôle spécifique dans l’amélioration de la performance :

- L’élimination de code mort : Supprimer les instructions inutiles, comme émonder un rosier pour qu’il ne garde que ses plus belles fleurs.

- La propagation de constantes : Remplacer des variables par leurs valeurs constantes connues à la compilation, simplifiant ainsi les calculs.

- L’inlining de fonctions : Intégrer le corps d’une petite fonction directement là où elle est appelée, évitant le coût d’un appel.

- La vectorisation : Exécuter une même opération sur plusieurs données simultanément, exploitant les unités SIMD (Single Instruction, Multiple Data) des architectures modernes. C’est le chœur qui chante à l’unisson !

- La réorganisation des boucles : Déroulement (unrolling), fusion, échange – des techniques pour maximiser l’utilisation du cache et le parallélisme.

- L’allocation de registres : Assigner intelligemment les variables aux registres du processeur, les plus rapides des mémoires, pour réduire les accès coûteux à la mémoire principale.

Ces techniques ne sont pas appliquées au hasard, mais selon des stratégies complexes et souvent heuristiques, guidées par des modèles des architectures cibles. C’est ici que l’ingéniosité humaine, incarnée dans l’algorithmique du compilateur, se marie à la rigueur scientifique.

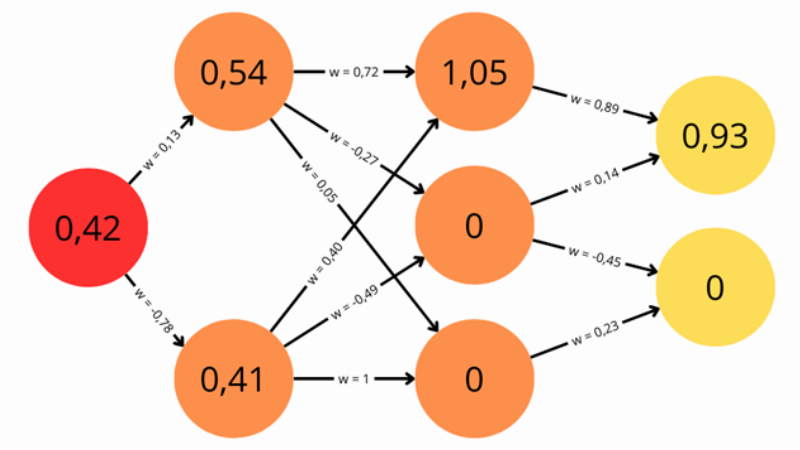

L'interface d'un compilateur moderne affichant les étapes d'optimisation du code pour une architecture de processeur complexe, symbolisant la précision de l'ingénierie logicielle française.

L'interface d'un compilateur moderne affichant les étapes d'optimisation du code pour une architecture de processeur complexe, symbolisant la précision de l'ingénierie logicielle française.

Le Chemin de l’Optimisation : Un Guide Étape par Étape

Aborder l’optimisation des compilateurs pour architectures modernes, c’est s’engager dans un voyage méthodique, où chaque étape contribue à affiner le résultat final. Suivez le guide, comme pour une recette de cuisine française, où la précision des gestes garantit la réussite du plat.

Comment le processus d’optimisation se déroule-t-il, pas à pas, au sein d’un compilateur moderne ?

Le processus d’optimisation se déroule en plusieurs étapes : d’abord, le code source est analysé lexicalement et syntaxiquement ; puis, une représentation intermédiaire est générée. C’est sur cette représentation que sont appliquées les différentes passes d’optimisation, suivies de l’allocation de registres et de la génération du code machine final.

Analyse Front-End (Analyse Lexicale et Syntaxique) : C’est la première lecture du code. Le compilateur décompose le texte en « mots » (tokens), puis vérifie la grammaire du langage. Il construit un arbre de syntaxe abstrait (AST), une représentation structurée du code. Pensez-y comme à la première ébauche d’une pièce de théâtre, où les mots sont posés et la structure définie.

Génération de la Représentation Intermédiaire (IR – Intermediate Representation) : L’AST est ensuite converti en une forme plus simple et plus flexible, appelée IR. C’est le langage universel interne du compilateur, indépendant de la source et de la cible. C’est sur cette IR que la plupart des optimisations seront appliquées. On passe de l’ébauche au script détaillé, prêt à être mis en scène.

Les Passes d’Optimisation (Optimisation Middle-End) : C’est le cœur du travail. Ici, le compilateur applique une série d’heuristiques et d’algorithmes pour transformer l’IR. Ces passes peuvent être générales (élimination de sous-expressions communes, propagation de copies) ou plus spécifiques (optimisations de boucles). L’ordre dans lequel ces passes sont appliquées est crucial et peut avoir un impact significatif sur la performance finale. C’est le moment où le metteur en scène affine le jeu des acteurs, ajuste les dialogues, pour que chaque scène soit parfaite.

Optimisation Back-End (Génération de Code et Allocation de Registres) : Une fois l’IR optimisée, le compilateur doit la traduire en instructions spécifiques à l’architecture cible. Cela inclut la sélection des instructions machine appropriées et, surtout, l’allocation des registres du processeur. Une bonne allocation minimise le nombre de chargements et de stockages en mémoire. C’est la touche finale, où le scénario devient un film avec ses acteurs et son décor définitif.

Génération du Code Machine Final : Le résultat est le fichier binaire exécutable, prêt à tourner sur l’architecture moderne.

Ce processus itératif et sophistiqué est le fruit de décennies de recherche en informatique, un véritable chef-d’œuvre d’ingénierie où chaque choix, chaque algorithme, est pesé et mesuré pour extraire la quintessence de la performance.

Astuces de Maître et Variations Créatives à la Française

Pour exceller dans l’optimisation des compilateurs pour architectures modernes, il ne suffit pas de suivre les étapes ; il faut y ajouter cette touche d’ingéniosité et de finesse, ce « je ne sais quoi » qui caractérise l’approche française de tout défi.

Quels conseils donneriez-vous pour maximiser l’efficacité de l’optimisation des compilateurs ?

Pour maximiser l’efficacité, il est essentiel de profiler le code avant et après l’optimisation pour identifier les goulots d’étranglement, de choisir le bon niveau d’optimisation du compilateur, et de comprendre les spécificités de l’architecture cible, comme la taille du cache ou le nombre de cœurs.

Voici quelques conseils, hérités de l’esprit pratique et ingénieux :

- Connaissez votre « terroir » : L’Architecture Cible : Tout comme un vigneron connaît son sol, vous devez comprendre l’architecture sur laquelle votre code s’exécutera. Est-ce un processeur Intel ou ARM ? Combien de cœurs ? Quelle est la taille des caches L1, L2, L3 ? Possède-t-il des unités vectorielles AVX ou NEON ? Plus le compilateur a d’informations sur la cible, plus ses optimisations seront pertinentes. Utilisez les flags

-marchet-mtuneavec sagesse. - « Dégustez » votre code : Le Profilage : Ne compilez pas à l’aveugle ! Utilisez des profileurs (comme

perfsous Linux, ou des outils Intel VTune) pour identifier les sections de votre code qui consomment le plus de temps CPU. C’est là que l’effort d’optimisation sera le plus rentable. C’est comme identifier le plat qui manque de sel pour le sublimer. - Ne craignez pas l’expérimentation : Les Niveaux d’Optimisation : Les compilateurs offrent différents niveaux d’optimisation (par exemple,

-O0,-O1,-O2,-O3,-Os,-Ofastavec GCC/Clang).-O3est souvent un bon point de départ, mais n’hésitez pas à tester-Ofastpour des applications gourmandes en calcul (attention aux floats !) ou-Ospour la taille du binaire. Chaque programme est unique, comme chaque millésime. - Le petit plus : Optimisations inter-procédurales (IPO) : Parfois, l’optimisation d’une seule fonction ne suffit pas. L’IPO (InterProcedural Optimization), activée avec des flags comme

-flto(Link Time Optimization), permet au compilateur de voir l’ensemble du programme et d’optimiser au-delà des frontières des fonctions individuelles. C’est la vision d’ensemble, l’harmonie parfaite de tous les éléments.

La Valeur Inestimable de l’Optimisation : Performance et Bienfaits

L’équivalent de la « valeur nutritionnelle et des bénéfices pour la santé » en matière d’optimisation des compilateurs pour architectures modernes se mesure en gains de performance, en efficacité énergétique et en capacité à repousser les limites du possible. C’est le carburant qui fait avancer la science, l’ingénierie et l’innovation, un pilier fondamental de notre société numérique.

Quels sont les bénéfices directs et indirects d’une optimisation efficace des compilateurs ?

Les bénéfices directs incluent une exécution plus rapide du code, une réduction de la consommation d’énergie et une utilisation plus efficiente des ressources matérielles. Indirectement, cela permet le développement d’applications plus complexes, l’amélioration de l’expérience utilisateur et des avancées dans des domaines comme l’IA ou la simulation scientifique, réduisant l’empreinte carbone des calculs.

- Rapidité d’exécution : C’est le bénéfice le plus évident. Un code optimisé s’exécute plus vite, ce qui signifie des temps de réponse réduits pour les utilisateurs, des calculs scientifiques qui s’achèvent en heures plutôt qu’en jours, et des analyses de données massives réalisées en un clin d’œil. Pour l’amour de la France, nous voulons que nos algorithmes soient les plus véloces !

- Efficacité énergétique : Moins d’instructions exécutées, ou des instructions exécutées plus efficacement, c’est aussi moins d’énergie consommée. C’est un enjeu majeur pour les centres de données, les appareils mobiles et pour l’environnement. Un code optimisé, c’est un code plus « vert ».

- Exploitation maximale des architectures modernes : Sans optimisation, les capacités des processeurs modernes (multicoeur, SIMD, caches) resteraient sous-exploitées. L’optimisation est la clé qui libère leur plein potentiel, rendant possible des innovations qui seraient autrement inaccessibles.

- Réduction des coûts : Des serveurs plus performants nécessitent moins de serveurs pour la même charge de travail, ce qui réduit les coûts d’achat, de maintenance et d’énergie.

- Amélioration de l’expérience utilisateur : Pour les applications grand public, une meilleure performance se traduit par une interface plus fluide, des chargements plus rapides, et une satisfaction accrue des utilisateurs.

L’Ingénieur Sophie Leclerc, figure montante dans l’ingénierie des systèmes embarqués, souligne avec passion : « Chaque pourcentage de gain en performance grâce à l’optimisation, c’est une porte qui s’ouvre pour nos innovations futures. C’est le sang de nos systèmes numériques. »

Savourer la Performance : Évaluation et Intégration des Stratégies d’Optimisation

Comment « déguster » et « marier » ces optimisations pour en tirer la quintessence ? C’est une question de mesure et de stratégie, une alchimie délicate qui demande un palais averti.

Comment évaluer l’efficacité de l’optimisation et l’intégrer au mieux dans les projets ?

L’efficacité de l’optimisation s’évalue principalement par des métriques de performance comme le temps d’exécution, la consommation mémoire et énergétique, obtenues via le profilage et les benchmarks. L’intégration se fait en choisissant judicieusement les flags de compilation, en effectuant des tests rigoureux et en adaptant le code source aux meilleures pratiques d’optimisation quand le compilateur seul ne suffit pas.

Mesurer avec Précision : Les Benchmarks et le Profilage : Pour savoir si une optimisation a porté ses fruits, il faut la mesurer. Utilisez des jeux de données réels ou représentatifs et des outils de benchmarking fiables. Comparez les temps d’exécution, la consommation CPU, l’utilisation de la mémoire. Le profilage est votre meilleur allié pour identifier les “hot spots” (points chauds) de votre code.

Choisir son Compilateur et ses Flags avec Discernement : Chaque compilateur (GCC, Clang, Intel, Microsoft Visual C++) a ses propres forces et faiblesses. Testez-en plusieurs si possible. De même, les flags d’optimisation ne sont pas une taille unique. Apprenez à les manipuler comme un grand chef ses épices.

L’Art de la Collaboration : Le Code et le Compilateur : Parfois, même le meilleur compilateur ne peut pas tout faire. Un code source bien écrit, en tenant compte des principes d’optimisation (par exemple, favoriser les accès mémoire contigus pour un bon comportement cache, éviter les branches imprédictibles), facilitera grandement le travail du compilateur. C’est une danse entre le programmeur et l’outil.

[lien interne vers les techniques de programmation performante]L’intégration continue et les tests de régression : Les optimisations peuvent parfois introduire des bugs subtils. Il est essentiel d’intégrer les étapes d’optimisation dans une chaîne d’intégration continue et de disposer de tests de régression robustes pour s’assurer que la fonctionnalité du code n’est pas altérée malgré les gains de performance. La rigueur, encore et toujours, pour l’amour du code parfait.

Questions Fréquemment Posées sur l’Optimisation des Compilateurs

Pour clore cette exploration, abordons quelques interrogations courantes, avec la clarté et la précision que l’on attend de l’esprit français.

Est-ce que toutes les optimisations des compilateurs sont toujours bénéfiques ?

Non, toutes les optimisations ne sont pas toujours bénéfiques. Certaines optimisations agressives peuvent augmenter la taille du code, ce qui peut paradoxalement ralentir l’exécution en raison de l’utilisation accrue du cache d’instructions. D’autres peuvent affecter la capacité de débogage du code. Le choix des optimisations doit être fait judicieusement, en fonction des objectifs spécifiques du projet.

Quelle est la différence entre l’optimisation de haut niveau et l’optimisation de bas niveau ?

L’optimisation de haut niveau opère sur la représentation intermédiaire du code (IR) à un niveau plus abstrait, par exemple en transformant des boucles ou des structures de données. L’optimisation de bas niveau travaille plus près du matériel, sur le code assembleur, pour des tâches comme l’allocation de registres, la planification des instructions ou la vectorisation spécifique à l’architecture.

Les langages de programmation influencent-ils l’efficacité de l’optimisation ?

Oui, les langages de programmation influencent grandement l’efficacité de l’optimisation. Les langages de bas niveau comme le C ou le C++ offrent plus de contrôle direct sur le matériel, permettant aux compilateurs des optimisations très fines. Les langages à plus haut niveau d’abstraction (Python, Java) ont leurs propres mécanismes d’exécution (machines virtuelles, interpréteurs) qui peuvent limiter certaines optimisations traditionnelles.

Qu’est-ce que l’optimisation basée sur le profil (PGO) ?

L’optimisation basée sur le profil (Profile-Guided Optimization ou PGO) est une technique où le compilateur utilise des données de profilage (informations sur les chemins d’exécution les plus fréquents, les boucles les plus critiques) recueillies lors de l’exécution d’un programme avec des données représentatives pour prendre des décisions d’optimisation plus éclairées lors d’une recompilation ultérieure. Cela permet une optimisation des compilateurs pour architectures modernes bien plus ciblée et efficace.

Est-ce que l’optimisation est seulement pour les supercalculateurs et les codes scientifiques ?

Non, l’optimisation n’est pas réservée aux supercalculateurs. Bien que cruciale pour les applications scientifiques et le calcul haute performance, elle est également fondamentale pour les systèmes embarqués (où les ressources sont limitées), les applications mobiles (pour l’autonomie de la batterie et la réactivité), les jeux vidéo (pour les fréquences d’images), et les infrastructures cloud (pour l’efficacité des serveurs).

Comment les compilateurs gèrent-ils les architectures hétérogènes (CPU + GPU) ?

Pour les architectures hétérogènes, les compilateurs modernes intègrent souvent des fonctionnalités spécifiques comme l’OpenMP offloading, OpenACC, ou la compilation CUDA/OpenCL. Ils peuvent générer du code pour différentes cibles (CPU et GPU) et gérer le transfert de données entre ces unités, permettant ainsi une optimisation des compilateurs pour architectures modernes complexes et diversifiées.

Conclusion : L’Éloge de la Performance à la Française

Ainsi s’achève notre voyage au cœur de l’optimisation des compilateurs pour architectures modernes, une discipline qui allie la rigueur de l’ingénierie à la finesse de l’art. Nous avons vu que, loin d’être un simple ajustement technique, l’optimisation est une quête d’excellence, une manière de respecter les ressources de nos machines et d’honorer la puissance de l’innovation. C’est une démarche qui, pour l’amour de la France et de son génie, pousse chaque instruction, chaque cycle d’horloge, à son apogée.

Les bénéfices sont clairs : une rapidité accrue, une meilleure efficacité énergétique, et la capacité à repousser les frontières de ce que nos machines peuvent accomplir. L’approche française, caractérisée par sa clarté, sa logique et sa recherche de la perfection, trouve ici un terrain d’expression privilégié. Nous vous encourageons, chers lecteurs, à vous approprier ces concepts, à expérimenter avec vos propres codes, et à partager vos découvertes. Car c’est dans cette quête collective de la performance que réside l’avenir de notre monde numérique, un monde toujours plus rapide, plus efficace, plus brillant grâce à l’optimisation des compilateurs pour architectures modernes. Vive l’ingénierie, vive la performance, vive la France !